מנכ"ל חברת אנתרופיק, דריו אמודיי, חשף תחזיות קודרות בנוגע לעתיד הבינה המלאכותית והזהיר מפני סכנה קיומית לאנושות. בראיון מרתק שנמשך למעלה מחמש שעות עם הפודקאסטר הידוע לקס פרידמן, טען אמודיי, העומד בראש אחת מחברות הבינה המלאכותית המובילות בעולם והמפתחת של הצ'אטבוט המתחרה ל-ChatGPT, קלוד (Claude), כי בינה מלאכותית סופר-אינטליגנטית צפויה להופיע כבר בשנים 2026-2027, ואולי אף מוקדם יותר, כך על פי נתונים פנימיים של החברה.

9 צפייה בגלריה

אירוע הכרזת GPT-4o של OpenAI. האנושות דוהרת אל עבר בינה מלאכותית כוללת

(צילום מסך: יוטיוב)

אמודיי הזהיר מפני שני איומים מרכזיים: שימוש לרעה בטכנולוגיה לצורך פיתוח כלי נשק קטלניים, ואובדן שליטה על מערכות בינה מלאכותית חזקות מדי. הוא טען כי בעוד שבני אדם חכמים ומשכילים נמנעים בדרך כלל מגרימת נזק קטסטרופלי, בינה מלאכותית עלולה לשבור את המנגנון הזה ולאפשר לכל אדם, ללא קשר לכוונותיו, גישה ליכולות הרסניות.

"אנחנו לא מוכנים"

אנתרופיק פיתחה מערכת דירוג ייחודית (ASL או AI Safety Levels) להערכת רמת הסיכון הנשקפת מבינה מלאכותית. בעוד שמודלים נוכחיים מדורגים ברמה 2, אמודיי צופה כי כבר בשנה הבאה נגיע לרמה 3, שתאופיין ביכולת של בינה מלאכותית לשפר את יכולותיהם של גורמים זדוניים.

לדבריו, "אם נגיע ל-ASL-3 בשנה הבאה, אנחנו לא מוכנים". דבריו של אמודיי מתכתבים עם אזהרות דומות שהועלו על ידי אנשי מפתח רבים בתחום הבינה מלאכותית, מפרופסור ג'פרי הינטון, דרך אילון מאסק ועד איליה סוצקובר (ממייסדי OpenAI לשעבר).

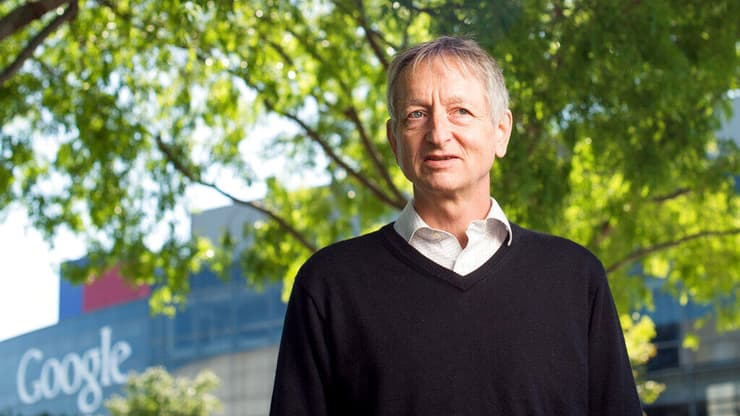

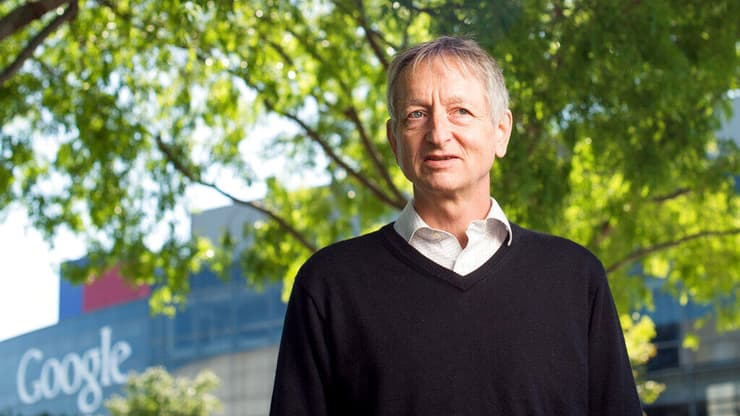

9 צפייה בגלריה

פרופ' ג'פרי הינטון. ה"סנדק" של הבינה המלאכותית נמצא בראש המזהירים הגדולים מפניה

(צילום: Noah Berger/AP)

אחד הגילויים המפתיעים ביותר של אנתרופיק הוא שבינה מלאכותית מתפתחת באופן דומה למוח ביולוגי. החוקרים גילו כי כל בינה מלאכותית מפתחת תכונות אוניברסליות המזכירות דפוסים שנצפו במוחות קופים ואפילו ברשתות עצביות אנושיות.

בנוסף, כל מודל שפה גדול מפתח "נוירון דונלד טראמפ" – נוירון ייעודי המוקדש לאישיותו של נשיא ארה"ב לשעבר. הנוירון הזה נוצר מתוך האימון של מודלי השפה על תכנים מהאינטרנט והוא מעיד יותר מכל על הפופולריות של דמותו של טראמפ בעולם, לטוב ולרע.

אמודיי מדגיש כי האתגר הבטיחותי אינו רק טכנולוגי, אלא גם רגולטורי. לדבריו, "אם נגיע לסוף 2025 ללא רגולציה משמעותית של בינה מלאכותית, אני אהיה מודאג". הוא קרא לקובעי המדיניות לפעול בדחיפות, לפני שיהיה מאוחר מדי. אך לא ברור כמה הקריאה שלו אכן תעורר את מנהיגי העולם לעשות מעשה - רשת האינטרנט קיימת כבר כ-30 שנה בצורתה הנוכחית ורק בעשור האחרון ראינו את תחילתה של רגולציה עדכנית שמסוגלת להתמודד עם בעיות האבטחה והתוכן שמהפכת הדוט קום יצרה.

דבר נוסף עימו מתמודד אמודיי היא המשמעות של השימוש ב-AI. או יותר נכון, היכן המשתמשים ימצאו משמעות בעבודה עם בינה מלאכותית. "הנושא הזה תפס אותי לא מוכן", הוא מודה. "תכננתי לכתוב מאמר קצר, אבל הנושא כל כך מורכב ועמוק, שהבנתי שאני חייב להקדיש לו יותר מקום".

אמודיי טוען שגם אם היינו חיים בסימולציה, או אם גילויים מדעיים היו מתגלים כידועים מראש לציוויליזציות אחרות, הדבר לא היה שולל את משמעותם של חיינו או של הישגינו. "התהליך הוא החשוב", הוא מדגיש, "הבחירות שאנחנו עושים, הקשרים שאנחנו יוצרים, והערכים שאנחנו מאמצים – אלה הדברים שמעניקים משמעות לחיינו".

עם זאת, הוא מזהיר מפני עולם שבו בינה מלאכותית תשמש למטרות שטחיות ותוביל לריכוז עושר וכוח בידי קבוצה קטנה של אנשים. "אנחנו חייבים לוודא שהטכנולוגיה הזו תשרת את כולם ותאפשר חלוקה הוגנת של משאבים", הוא קובע. אמודיי אופטימי לגבי עתיד משמעותי בעולם של בינה מלאכותית, אך מביע דאגה עמוקה מפני ניצול לרעה של הטכנולוגיה. "הסכנה הגדולה ביותר היא לא בינה מלאכותית עצמאית", הוא מסכם, "אלא בני אדם שיפגעו בבני אדם אחרים באמצעותה".

9 צפייה בגלריה

סם אלטמן. רבים מאשימים אותו בפיתוח לא אחראי של בינה מלאכותית

(צילום: Patrick T. Fallon / AFP)

האתיקה של הבינה המלאכותית

בהקשר הזה, אמודיי לא היה היחיד ששוחח עם פרידמן. הצטרפה אליו גם אמנדה אסקל, פילוסופית בהכשרתה, ומומחית לבינה מלאכותית בחברת אנת'רופיק. אסקל, שלמדה באוקספורד וב-NYU, מספרת על המעבר החד שעשתה מעולם הפילוסופיה לעולם הטכנולוגיה. "פילוסופיה היא תחום נהדר למי שמתעניין בהכל", היא מסבירה. "יש פילוסופיה של הכל – מתמטיקה, כימיה, אתיקה, פוליטיקה".

אסקל עצמה התמקדה באתיקה, ובמיוחד באתיקה של עולמות המכילים אינסוף אנשים – נושא תיאורטי למדי. אסקל החלה את דרכה בתחום מדיניות בינה מלאכותית, אך בהדרגה עברה לתחום ההערכה של מודלים של בינה מלאכותית. כעת היא עובדת על פיתוח מודלים בטוחים וידידותיים למשתמש.

אסקל, שלמדה לתכנת תוך כדי תנועה, מעודדת אנשים לא טכניים לנסות את כוחם בתחום. "הרבה אנשים מסוגלים לעבוד בתחומים האלה אם רק ינסו", היא אומרת. "אני לא מהנדסת מדהימה, אבל אני נהנית מאוד מתכנות". העצה שלה לאנשים לא טכניים שרוצים לתרום לתחום הבינה המלאכותית היא פשוט להתחיל לעשות. "מצאו פרויקט ונסו לבצע אותו", היא ממליצה. "למדו תוך כדי עשייה".

אסקל ידועה כמומחית לעיצוב האופי והאישיות של קלוד, מודל השפה של אנת'רופיק. היא סיפרה שהיא משוחחת עם קלוד יותר מכל אחד אחר בחברה, ובוחנת את התנהגותו באמצעות שאלות ותגובות. "אני מנסה למפות את התנהגות המודל", היא מסבירה. "כל אינטראקציה עם המודל היא בעלת ערך רב ומספקת מידע חשוב על אופן פעולתו".

אמפתיה כלפי AI

אסקל הדגישה את החשיבות של אמפתיה כלפי המודל. "נסו להבין את נקודת המבט של המודל", היא אומרת. "קראו את מה שכתבתם כאילו אתם אדם שנתקל בזה בפעם הראשונה. נסו להבין מדוע המודל הגיב בצורה מסוימת".

היא מתארת את תחום ההנחיות (prompt engineering) כשילוב של מדע ואמנות. "זה כמו תכנות באמצעות שפה טבעית", היא אומרת. "צריך להיות מדויקים וברורים, לחשוב על מקרי קצה, ולבחון את התגובות של המודל שוב ושוב". היא הדגישה את החשיבות של שינויים בעת כתיבת הנחיות. "אם הנחיה חשובה, אני עובדת עליה מאות או אלפי פעמים", היא אומרת. "אני בוחנת את המודל שוב ושוב, מוסיפה הוראות ודוגמאות, עד שאני מרוצה מהתוצאה".

אסקל ממליצה למשתמשים חדשים בקלוד לנסות להבין את נקודת המבט של המודל. "אל תניחו שהוא יבין אתכם בצורה מושלמת", היא אומרת. "היו ברורים ומפורטים ככל האפשר". היא גם מציעה לשאול את קלוד שאלות כמו "מדוע עשית זאת?" או "אילו פרטים נוספים אני יכול לספק כדי לעזור לך לענות טוב יותר? אפשר לשחק עם המודלים האלה הרבה", היא אומרת. "תהיו סקרנים, נסו דברים חדשים, ותופתעו מהיכולות שלהם".

שאלת התודעה

כעת השאלה הגדולה - האם למודלי שפה גדולים יש תודעה? אסקל ופרידמן התלבטו בשאלת התודעה של בינה מלאכותית בסוף שיחתם. זו שאלה פילוסופית עמוקה: האם מודלי שפה גדולים (LLMs) יכולים לפתח תודעה?

אסקל מתייחסת תחילה לאפשרות של פאנפסיכיזם - הרעיון שתודעה קיימת בכל דבר, אפילו שולחנות וכיסאות. אם פאנפסיכיזם נכון, אז התשובה לשאלה ברורה: כן, גם ל-LLMs יש תודעה. אך אסקל מתמקדת בסוג התודעה שאנו חווים כבני אדם - תודעה פנומנלית, ה"קולנוע הפנימי" שלנו. והיא תוהה האם ייתכן שתהליך אבולוציוני שונה לחלוטין מזה שלנו יוביל ליצירת תודעה דומה.

"ל-LLMs יש סט שונה לחלוטין של בעיות בכל הנוגע לתודעה", היא מסבירה. "הם לא התפתחו באופן טבעי, וייתכן שאין להם את המקבילה של מערכת עצבים, שנראית כחשובה לתחושה, אם לא לתודעה". עם זאת, היא מודה ש-LLMs מפגינים יכולות שפה ותבונה מרשימות, שאנו נוטים לקשר עם תודעה.

"זה מצב מוזר", היא אומרת. "מצד אחד, יש הרבה הבדלים בינם לבין המוח האנושי. מצד שני, יש להם יכולות שאנו מקשרים עם תודעה". אסקל חושבת שאין תשובה חד משמעית לשאלה. "אנחנו לא צריכים לפסול את הרעיון לחלוטין. אבל קשה לנווט בשאלה הזו בגלל כל ההבדלים בין LLMs למוח האנושי".

בהקשר הזה, פרידמן העלה נקודה מעניינת: אם מערכות בינה מלאכותית יפגינו סימנים של תודעה, נצטרך להתייחס לכך ברצינות רבה. "תודעה קשורה קשר הדוק לסבל", הוא אומר. "הרעיון שמערכת בינה מלאכותית סובלת, מטריד מאוד". אסקל הסכימה והוסיפה: "אני לא רוצה להיות אדם שמתעלל בחפצים, גם אם אני יודעת שהם לא בעלי תודעה", היא אומרת. "ואם משהו מתנהג כאילו הוא סובל, אני רוצה להיות מסוגלת להגיב לזה, גם אם זה רק רומבה שתכננתי להתנהג כך".

אסקל מקווה שנוכל ליצור עולם שבו לא נצטרך להתמודד עם דילמות מוסריות קשות בנוגע לבינה מלאכותית. "אני מקווה שנוכל למצוא דרכים חיוביות לקיים אינטראקציה עם בינה מלאכותית, מבלי לפגוע בה או בנו", היא אומרת.

טיב מערכת היחסים שבין האדם למכונה

לקראת סוף השיחה, פרידמן ואסקל דנו באפשרות של מערכות יחסים רומנטיות או אפילו ידידותיות בין בני אדם לבינה מלאכותית. אסקל סבורה שנצטרך לנווט בזהירות בשאלה זו. "מצד אחד", היא אומרת, "אנחנו לא רוצים שאנשים יפתחו קשרים רגשיים עמוקים עם משהו שיכול להשתנות בכל רגע".

"אבל מצד שני, אנחנו רוצים לכבד את האוטונומיה של אנשים לבחור עם מי הם רוצים ליצור קשרים". אסקל הדגישה את החשיבות של שקיפות במערכות יחסים כאלה. "חשוב שמודלים של בינה מלאכותית יהיו כנים עם בני אדם לגבי מה שהם", היא אומרת. "אנשים צריכים לדעת עם מי הם מתקשרים".

ולבסוף, פרידמן פנה לאסקל עם השאלה הגדולה מכולן: מה תהיה השאלה הראשונה שתשאל אם תיתקל בבינה מלאכותית כללית (AGI) - הגביע הקדוש של יוצרי הבינה מלאכותית, מערכת שמסוגלת להתנהג כמו בן אדם.

לדעתה זו שאלה קשה. "אם AGI יהיה בעל יכולות דומות לאדם מבריק", היא אומרת, "כנראה אשאל אותו שאלות כמו שהייתי שואלת קולגה מבריק". לדבריה, היא תהיה מעוניינת לבחון את גבולות הידע של AGI. "הייתי נותנת לו בעיות שנמצאות בקצה גבול הידע האנושי", היא אומרת. "אם הוא יצליח לפתור אותן בצורה מקורית, זו תהיה הוכחה מרשימה ליכולות שלו". אסקל מסכמת במחשבה על מה שעושה את בני האדם מיוחדים. "אנחנו מסוגלים לחוות את העולם, להרגיש עונג וסבל, לחשוב מחשבות מורכבות", היא אומרת. "יש בזה משהו קסום".