"אני כמעט אף פעם לא מתעניין בהווה - ואם כן זה רק במה שלא בסדר בו", הודה בחיוך יאן לקון, מדען ה-AI הראשי של מטא, בפתיחת דבריו בכנס מיוחד בשם "בונים את העתיד" של מעבדות FAIR העוסקות בחקר התחום של בינה מלאכותית. לפני עשור התבקש לקון על ידי מארק צוקרברג להצטרף ולהוביל את מאמצי החברה - שנקראה אז עוד פייסבוק - בתחומי ה-AI, ואילו בשנת 2019 זכה בפרס טיורינג היוקרתי, לצד עמיתיו יהושוע בנג'יו וג'פרי הינטון, על תגליות חשובות בתחומי הלמידה העמוקה - מה שזיכה את השלושה בכינוי "סנדקי הבינה המלאכותית".

עוד כתבות שיעניינו אתכם:

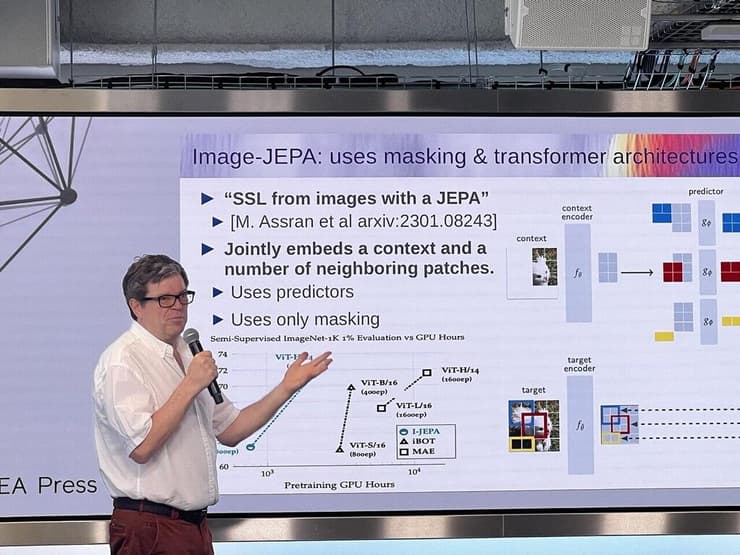

במהלך הכנס הכריז לקון על מודל ראייה ממוחשבת בשם I-JEPA, שמציע פיתרון מסוג חדש לחסרונות הבולטים של מערכות בינה מלאכותית גנרטיבית, ושואף לפעול בצורה קרובה יותר לאופן הפעולה של המוח האנושי. המודל החדש שוחרר בקוד פתוח - כמו מודלים ומחקרים רבים מתוצרת מעבדות ה-AI של מטא, ואילו לקון הסביר באריכות כיצד מודל זה משתלב בחזון הכללי שלו לגבי עתיד התחום כולו.

"המטרה היא להצליח לבנות מכונות שהן חכמות כמו בני אדם - אם לא יותר", אמר לקון, "והדבר הזה כמובן מעורר את השאלה מהי בכלל אינטליגנציה אנושית?". לקון הסביר כי המודלים הגנרטיביים שהפכו פופולריים במיוחד בשנתיים האחרונות, דוגמת GPT, עמוסי ליקויים וחסרונות. "המודלים האלה מאומנים על מערכות דאטה עצומות ומתויגות היטב - אבל הם לא מסוגלים להבין דברים בסיסיים על העולם", אמר.

מודלי שפה גדולים (LLM) אוטו-רגרסיביים לא מסוגלים להביא בחשבון מידע עדכני בזמן אמת, לא יודעים להפיק תשובות עקביות ונכונות עובדתית, אין בהם שום תהליך של הסקת מסקנות או תכנון, הם לא יודעים מתמטיקה והם גם לא מסוגלים להשתמש בכלים כמו מנועי חיפוש, מאגרי מידע, מחשבונים וכדומה. "כשמשוחחים עם ChatGPT לדוגמה, המידע שמתקבל הוא לא מידע עובדתי ומדויק - מתקבלות מה שנקרא 'הזיות' של המכונה. השיחה תהיה שוטפת וקולחת וזה מה שגורם לנו לחשוב שהם אינטליגנטיים במיוחד - אבל למעשה מדובר במודלים לא טובים".

לקון חולם על מכונות שיוכלו ללמוד כפי שלומדים בטבע, ובוחן תהליכי למידה אצל תינוקות ובעלי חיים. הוא קורא בצורה מפורשת לנטוש מודלים גנרטיביים, וגם קצת מתלוצץ על האופן שבו הוא מסכן את המעמד שלו בתחום כשהוא יוצא בגלוי נגד המודלים הפופולריים ביותר היום. המטרה הסופית: יצירת מכונות שמסוגלות להבין, לתכן קדימה, לייצר תהליכים של הסקת מסקנות ולהשתמש בהיגיון בריא. לקון לא קורא לזה AGI (ביה מלאכותית כללית - AI עם יכולות ברמה אנושית). לטענתו "אין דבר כזה", והוא עומד על הצורך להבחין בין סוגים שונים של אינטליגנציה, כולל זו האנושית, ולייחד אותם. המערכות החדשות, לדבריו, יזדקקו פחות ופחות לפידבקים אנושיים ויתנו מראש תוצאות טובות יותר.

כמו בסרט Her

בשעה שהמתחרות הבולטות, גוגל ו-OpenAI, מודות בפה מלא שעוד אין להן מושג איך לייצר רווחים מהמודלים שלהן, העתיד לפי לקון נראה קצת אחרת. נכון, אף אחד פה לא ממש מדבר על מונטיזציה, מילה גסה בכל מעבדת מחקר שמכבדת את עצמה, אבל שנים קדימה לקון מדמיין מערכת אחת שמלווה אותנו בחיי היומיום כמעט בכל היבט. "כמו בסרט Her", הוא מודה, "זה תיאור לא רע של האופן שבו אנחנו נתקשר עם העולם הדיגיטלי בעתיד. זו תהיה מערכת שפועלת כל הזמן, שמסננת עבורנו מידע והופכת בהדרגה לחברה הכי טובה שלנו". מבחינת לקון, זה גלגול טבעי של הממשק בינינו לבין כל מה שדיגיטלי. "בהתחלה תיקשרנו עם העולם הזה באמצעות מנועי חיפוש, ואז באמצעות רשתות חברתיות, בשלבים הבאים זה יהיה באמצעות בינה מלאכותית שמסייעת לנו כל הזמן". עכשיו אפשר להתחיל לדמיין כמה יעלה לנו להשתמש בה.

"אבא שלי הוא מהנדס אווירונאוטיקה ומטוסים הם מהדברים הבטוחים בעולם, אבל בשנת 1930 אנשים התקשו לדמיין איך מנועי טורבו-סילון יוכלו להיות בטוחים מספיק. זה מפני שהם עוד לא הומצאו אז. זה בדיוק מה שקורה עם בינה מלאכותית היום"

לא ממש מודים בזה פה, אבל העובדה היא שמספר לא מבוטל של מדעני AI בחברה עושים בחודשים האחרונים את המעבר מהמעבדות ומתקרבים אל תחומי המוצר. המחקרים של FAIR עושים דרכם באופן תדיר אל המוצרים הקיימים של מטא, מזיהוי תוכן בלתי הולם באינסטגרם ועד איתור פייק ניוז בפייסבוק, אבל לא מן הנמנע שבחברה כבר חושבים איך לקחת את הסיפור הזה עוד כמה צעדים קדימה.

במטא גם נוקטים עמדה ברורה וגורפת בכל מה שקשור לשחרור מחקרים בקוד פתוח. הדלפת הפרמטרים של מודל LLaMA, מודל השפה של החברה שמתחרה ב-GPT, והשימושים לרעה שנעשו בו, הם בבחינת סיכון מחושב. כן, זה מבאס, אבל היתרונות עדיין עולים על החסרונות שבשיתוף מחקרי - כך מתעקשים פה. ההתעקשות הזאת ממצבת את מטא קצת אחרת מגוגל ו-OpenAI, שמתנגדות לקוד פתוח ואף טוענות שמדובר בסיכון לציבור. במטא, מנגד, טוענים שהסכנה האמיתית היא שמירה של המערכות החכמות האלה כקופסאות שחורות, מבלי שיש לנו יכולת להבין באמת כיצד הן פועלות.

לא מצטרף לבהלה

"יש לעסוק בסכנת ההכחדה בידי בינה מלאכותית ברמה הגלובלית כפי שעוסקים בסיכונים דוגמת מגפות ומלחמה גרעינית", כך נכתב רק לפני שבועיים בהצהרה קצרה במיוחד, בת 23 מילים בלבד, עליה חתמו כ-350 ממדעני ה-AI המובילים בעולם, כולל מנהל חטיבת ה-AI בגוגל, סם אלטמן ואיליה סוצקבר מ-OpenAI, וגם שותפיו של יאן לקון לזכייה בפרס טיורינג - יהושוע בנג'יו וג'פרי הינטון. לקון עצמו בחר שלא להצטרף לבהלה, והיעדרות השם שלו מהמכתב עוררה תהיות. המכתב הזה מצטרף למכתב פתוח נוסף שפורסם רק לפני שלושה חודשים, עליו חתמו, בין היתר, סטיב ווזניאק, אילון מאסק ויובל נח הררי, בקריאה להשהות פיתוחים בתחום הבינה המלאכותית.

"קריאות כאלה הן, הלכה למעשה, ניסיונות לבלום את הקידמה ואת המדע", אומר לקון. "אבא שלי הוא מהנדס אווירונאוטיקה ומטוסים הם מהדברים הבטוחים בעולם, אבל בשנת 1930 אנשים התקשו לדמיין איך מנועי טורבו-סילון יוכלו להיות בטוחים מספיק. זה מפני שהם עוד לא הומצאו אז. זה בדיוק מה שקורה עם בינה מלאכותית היום. אנשים מתקשים לדמיין איך אפשר לעצב AI בטוח עבור האנושות, אבל זה מפני שאנחנו רק בהתחלה".

לקון הוסיף כי "אינטליגנציה גבוהה היא לא בקורלציה עם דומיננטיות", וצחק ש"אף מדען לא רוצה להיות מנהל". לדבריו, "אנחנו משליכים על בינה מלאכותית את הטבע האנושי" כל כך של רצון בשליטה והשתלטות, אבל אין סיבה לחשוב שזה יהיה המצב כי את המערכות האלה אנחנו מפתחים, כלומר, בני האדם יכולים לשלוט במידת האייג'נסי (סוכנות) שמתוכנתת במערכות חכמות.

בהתייחס להיעדרות החתימה שלו משלל המכתבים הפתוחים הסביר כי מטא לוקחת חלק בדיונים כאלה ואחרים עם מוסדות בכל העולם בנושא של סכנות הבינה המלאכותית, כולל שיחה שלו עצמו עם עמנואל מקרון בשבוע שעבר, וכי "לאנשים שונים יש דעות שונות". לקון הוסיף שהוא עצמו לא מתנגד לרגולציה, אבל שזאת צריכה להתקיים ברמת המוצר ולא ברמת המחקר. לדבריו, העובדה שמטא החזיקה במודל שפה כמו LLaMA ולא שחררה אותו כמוצר לציבור (בדומה למה שעשו עם ChatGPT) מוכיחה שלחברה יש אחריות גדולה בנושא. "אם היינו משחררים מוצר כמו הצ'אט שמבוסס על המודל שלנו, והוא היה מתחיל לענות תשובות לא נכונות ולדבר שטויות כמו ChatGPT... אפשר רק לדמיין את הסערה הציבורית".

אתה עושה עבודה טובה בלהסביר למה אנחנו לא צריכים לחשוש מ-AI. יש משהו שכן מטריד את מנוחתך?

"שחקנים רעים. כלומר, שימושים שלא צפינו וניצול לרעה של המערכות החכמות שאנחנו בונים. זה כמובן משהו שאנחנו רואים עם כל פיתוח טכנולוגי. זמן לא קצר אחרי שהומצא המייל התחלנו לראות ספאם. בסופו של דבר בינה מלאכותית תדע להתמודד גם עם האתגרים האלה בעצמה, אבל אלה הסכנות המרכזיות".

הכותבת היא אורחת חברת מטא בפריז