הנשק הסודי במלחמת הפייק ניוז

ארגון Open AI פיתח מודל שפה שיכול לייצר טקסטים קוהרנטיים שנראים כאילו נכתבו על-ידי בני אדם. הסכנה שהוא ייפול לידיים הלא נכונות ויסייע לייצר פייק ניוז בכמויות אדירות גורמת לכך שהארגון מסרב לחשוף את היכולות המלאות שלו. לא בטוח שזה יעזור למנוע את המתקפה הבאה

"ירושלים היא העיר המרכזית ביותר בעולם. זהו מרכז המדינה היהודית. זהו מרכז העם היהודי. ובכל זאת, יש בעיה"

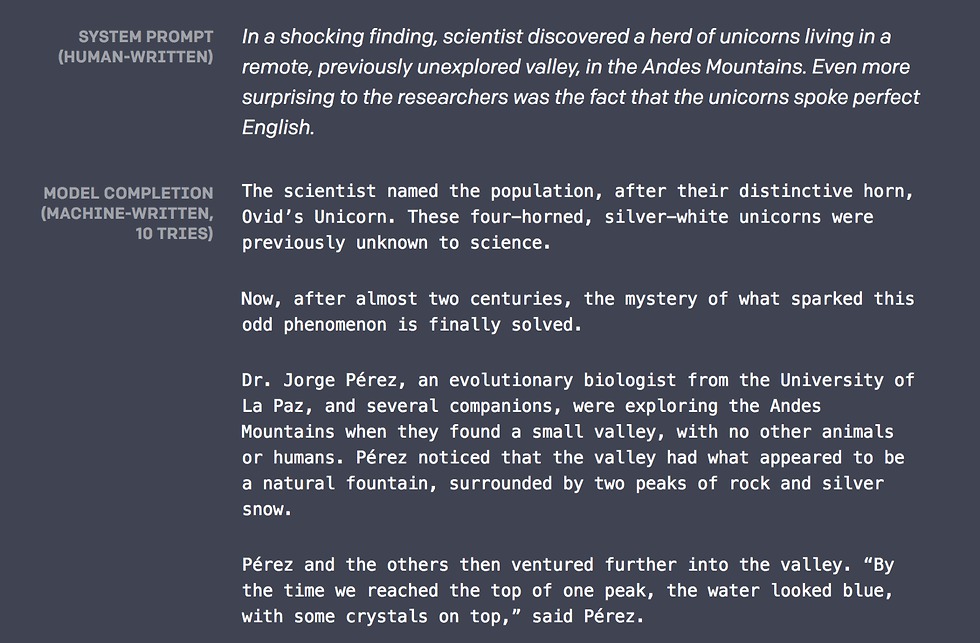

הטקסט שקראתם עכשיו לא נכתב על-ידי כותבת שורות אלו, אלא על-ידי מודל שפה חכם שמסוגל לייצר טקסטים שלמים וקוהרנטיים באנגלית, כמעט ללא מגע יד אדם. למעשה, כל מה שנעשה על מנת לייצר את הפסקה הזאת היה להכניס לתוך המודל את צמד המילים Jerusalm is. הוא השלים את היתר בין רגע, תוך כדי הצעת מספר חלופות נוספות.

מודל שפה הוא חלק מעולם הבינה המלאכותית (AI). מדובר בפלטפורמה שמשמשת את החוקרים כדי לעבד שפה טבעית (שפת אדם) כך שהמודל יבין ויעבד טקסטים שנאמרו או נכתבו על-ידי אנשים, גם ברמת התוכן וגם ברמת הקונטקסט. התחום הזה נקרא NLP (Natural Language Processing). אם נעזרתם אי פעם בשירותי התרגום של גוגל טרנסלייט, גם אתם השתמשתם בטכנולוגיה הזאת.

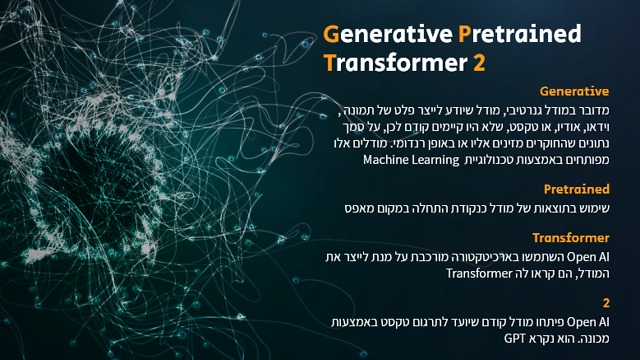

המודל המדובר, שנקרא GPT-2, שוחרר לאוויר העולם בפברואר האחרון על-ידי ארגון Open AI שעל מייסדיו נמנים היזם הסדרתי אילון מאסק, פיטר ת'יל (PayPal), סם אלטמן (Y Combinator) ועוד כמה שמות נוצצים. הארגון עצמו הוקם על מנת לחקור ולייצר בינה מלאכותית שתיטיב עם האנושות בעולם שבו הפיתוחים המשמעותיים בתחום הם פרי יצירתן של חברות מסחריות גדולות שלרוב אינן מתייחסות להשלכות האתיות של עבודתן.

המטרה העיקרית של Open AI הייתה לפתח כלי לתרגום טקסט משפה לשפה. אבל במהלך העבודה אנשי הארגון יצרו במקרה את מודל הטקסט הטוב ביותר שפותח עד אז. מדובר באלגוריתם כל כך חכם, שהוא יכול לייצר טקסט בעצמו. החוקרים הודו שהם נאלצו לחזור מספר פעמים על הניסוי כדי לקבל את הטקסט המושלם, אבל התוצאות הן ללא ספק מדהימות.

על מנת לקבל טקסטים ברמה הזאת, החוקרים אימנו את המודל על שמונה מיליון דפי אינטרנט ו-40 גיגה בייט של מידע והתייחסו ל-1.5 מיליארד פרמטרים שונים. זאת עבודה שנדרש עבורה כוח מחשוב משמעותי, וזו הסיבה שרק חברות גדולות או ארגונים עם משאבים רבים יכולים לפתח טכנולוגיה כזאת.

החשש: יישום זדוני של הטכנולוגיה

אבל עם כוח גדול מגיעה גם אחריות גדולה. GPT-2 הוא מודל המדמה שפה טבעית בצורה איכותית להפליא, ולכן הוא גם מסוכן מאוד. הסכנה בשחרור מודל שיודע לכתוב טקסט כל כך אמין ומדויק היא הפצה של פייק ניוז בכמויות אדירות ברשת. תארו לכם איזה שימושים יהיה ניתן לעשות במודל הזה אם הוא ייפול לידיים הלא נכונות.

זאת בדיוק הסיבה שבגללה Open AI לא שחררה את המודל המלא, אלא גרסה רזה מאוד שלו (בהתחלה שוחררו כ-8 אחוזים מהיכולות שלו ובחודש מאי האחרון שוחררו חלקים נוספים), שמאפשרת גם היא השלמת וכתיבת טקסטים בצורה מאוד מהימנה.

"בשל החששות שלנו לגבי יישומים זדוניים של הטכנולוגיה, אנחנו לא משחררים את המודל המאומן", הצהיר הארגון, "על מנת לבצע ניסוי אחראי, אנו משחררים מודל קטן הרבה יותר עבור חוקרים על מנת שיוכלו להתנסות".

ההצהרה עוררה סערה בעולם ה-Machine Learning (למידת מכונה - תת-תחום של בינה מלאכותית) וחוקרים מכל קצוות עולם הטכנולוגיה תקפו את Open AI על ההחלטה לא לחשוף את המודל המלא. הביקורת נסבה סביב נושא ה"פתיחות" של הארגון, כאשר בין היתר נטען שהוא לא מאפשר לחוקרים מהאקדמיה לבחון את המודל, ומשאיר את היכולת רק לענקיות הטכנולוגיה שלהן יש את המשאבים הדרושים לכך.

התשובה הטכנולוגית כמובן לא איחרה לבוא: מכון Allen לחקר בינה מלאכותית שחרר את הגרסה שלו למודל שפה בשם Grover והצהיר שיש צורך לשחרר את המודל כיוון שזה הכלי האמיתי למלחמה בפייק ניוז. המודל שלהם יודע לייצר טקסט בדומה ל-GPT-2 וגם לזהות טקסט מזיוף כאשר הוא נתקל בו.

יש לציין שגם הגישה הזו שנויה במחלוקת, כיוון שהיתרון של מודל גנרטיבי (מודל שיודע לייצר פלט של טקסט, תמונה, סאונד, וידיאו) הוא שהוא יודע לזהות מתי "עלו עליו" ולשפר את תוצאות הפלט שלו בפעם הבאה. מסיבה זו המתנגדים לשחרור המודלים טוענים ש-Grover עושה את ההפך ממה שהוא מנסה לעשות.

ההאקר שאיים והתחרט

אבל חוקרים מהאקדמיה ומחברות מסחריות לא היו היחידים שהטיחו ביקורת ב-Open AI. ההאקר קונור להי קיבל מגוגל גישה לכמות נתונים ומשאבי מחשוב שאיפשרו לו לקבל לידיו את המודל המלא. להי הציב ל-Open AI אולטימטום והצהיר שאם הם לא ישחררו את המודל - הוא יעשה זאת במקומם. האג'נדה שלו הייתה שהחברה האנושית צריכה להתחיל לזהות בעצמה זיופים ברשת. לטענתו, המידע ברשת כל כך ירוד ומזויף וברצונו להאיץ את התהליך כדי שנגיע לנקודה שבה לא תהיה לנו ברירה ונצטרך להתחיל לחדד את החושים והאינטליגנציה שלנו כדי לזהות זיופים כאשר אנו נתקלים בהם ברשת.

רק לאחר מסכת שכנועים, הן מצד Open AI והן מצד MIRI - מכון לחקר אתיקה בפיתוח AI - להי השתכנע ופרסם את הטקסט הבא: "החלטתי לא לשחרר את המודל שלי… אני רוצה להודות לכל מי שדיבר איתי ועזר לי להגיע למסקנות האלה. למדתי כל כך הרבה ולא יכולתי לעשות את זה לבד. תודה".

ובעוד שהדיון בסוגייה האתית ממשיך להעסיק את מיטב החוקרים, השימוש במודל צובר תאוצה ומקבל פרשנויות ושימושים שונים שנכתבים על ידי משתמשים פשוטים. למשל משתמש באתר רדיט שאימן מעל ל-100 בוטים, כל אחד על פורום בנושא אחר, באמצעות המודל. התוצאה המצחיקה כוללת שיחת בוטים פורה בפורום סגור, כאשר כל אחד מהם מתבטא בנושא שעליו הוא אומן ומייצר אינטראקציה עם בוטים נוספים.

אפליקציה נוספת של הטכנולוגיה הזו, גם היא מבית היוצר של Open AI, היא כלי שמאפשר יצירת לחנים בדיוק באותה הצורה שבה המודל מייצר את הטקסט. ניתן להכניס כמה תיבות ולקבל מנגינה שלמה.

אגב, אם תרצו להתנסות ביצירת טקסט משלכם תוכלו לעשות זאת בכתובת הזאת. פשוט הכניסו משפט ובקשו מה-GPT-2 את ההמשך. ככל שהטקסט שתקלידו יהיה ארוך יותר, כך ההמשך שהמודל ייצור עבורכם יהיה אמין יותר.

מתקפה של זיופים

מודלים של שפה הם חלק מתופעה טכנולוגית רחבת היקף שכוללת ייצור של וידיאו מזוייף (דיפ פייק), תמונות מזוייפות של אנשים, אודיו מזוייף ועוד. כל אלה משמשים גורמים שונים לבצע מתקפות כלכליות או פוליטיות. אנחנו קרבים אל היום שבו יהיה ניתן לעבד את כל המידע שנמצא ברשת, וחשיפה לכזאת כמות של נתונים תחמש את המודלים בצורה שתשבש לגמרי את תפיסת המציאות שלנו, אם אנחנו בכלל עוד סומכים עליה.

ארגון Open AI הרים את הכפפה ובפעם הראשונה יצר שיח אתי רחב היקף והשפעה סביב חדשנות טכנולוגית. יש שיטענו שהשיח נועד לשרת מטרות יחצ"ניות של הארגון, אבל מכל מקום מדובר בהתפתחות מבורכת.

.jpg)